看似微小的改变可以产生巨大的能量,尤其在科技产业发展进程中。

在数据智能时代,各类大模型的训练与应用正加速算力市场快速扩容,数据中心作为其承载,规模也越来越大,正成为一群巨大的吞电兽。

国家能源局数据显示,2020年我国数据中心耗电量突破2000亿千瓦时,能耗占全国总用电量2.7%。IDC则预计,到2024年数据中心耗电量将占到全社会耗电量的5%以上。

所以,降低数据中心碳排放势在必行,即是企业成本的要求,也是实现碳达峰碳中和目标的要求。

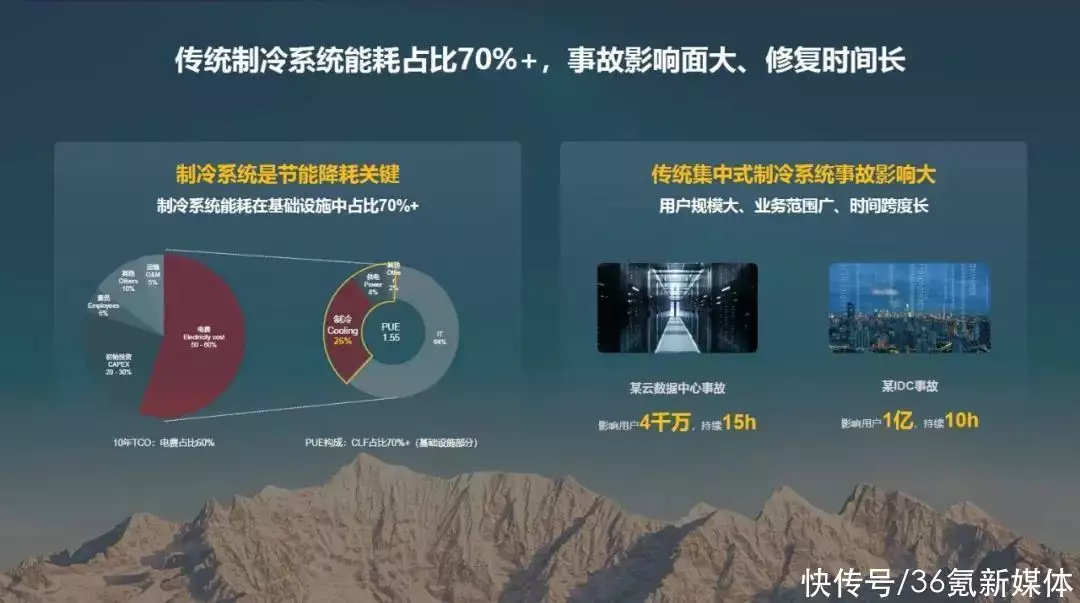

在算力承载的数据中心中,在非IT设备耗能中,冷却系统是耗能大户。据赛迪统计,以风冷技术为代表的传统数据中心,其耗能中约有43%用于IT设备的散热。所以,降低冷却系统能耗的创新将会实现微小改变创造巨大效益。

提及数据中心散热系统,目前大型数据中心主要以冷冻水方案为主。但从技术角度看,冷冻水系统主要由7大部件组成(冷水机组、冷却塔、蓄冷罐、温控末端、水泵、板换、管理系统等),系统复杂,导致其交付困难、交付周期长,不利于快速部署,难以适应未来不确定的IT业务需求。以一个12MW的数据中心为例,若是其使用冷冻水系统,从安装到调试一般需要6个月左右,制约业务快速上线。此外,冷冻水系统制冷链路长,换热层级多,从冷源到热源需要经过4次热交换,过程中热损耗大,制约了PUE的降低空间,且耗水量大,无法满足现有大型数据中心节水要求。

相较之下,间接蒸发冷却系统通过外界冷风与室内热风在换热芯内进行间接热交换,直接利用室外冷空气来给室内降温,既能大幅利用自然冷源来满足大型数据中心的节能诉求,又能避免外部空气对内部环境的影响,且间接蒸发冷却系统属于分布式模块化架构,每台间接蒸发冷却设备都是相对独立、相对解耦的,即使一台设备出现问题,也不会涉及到其他设备或系统。因此采用间接蒸发冷却系统的数据中心因此至今尚未发生大规模故障,间接蒸发冷却系统由此得到行业的广泛认可,风进水退、分布式架构成为数据中心冷却系统的发展趋势。

随着间接蒸发冷却系统的大规模应用,更多新技术也开始逐渐涌现,来保证其运行更可靠,让间接蒸发冷却系统从单机可靠走向全链可靠!

为了实现连续制冷,传统间接蒸发冷却方案需要在供电前端配置UPS以及电池,导致其动力配电方案复杂;另一方面,其在双路切换时压缩机会掉电重启(通常导致3-5分钟的制冷中断),这个时候可能会出现高温热点进而影响业务正常运行;此外,间接蒸发冷却设备运行由于其用电部件主要是变频压缩机以及变频风机,在运行过程中会产生大量谐波,目前业界间接蒸发冷却方案普遍满载运行谐波THDi在30%以上,动力设备供电链路因此存在安全隐患。

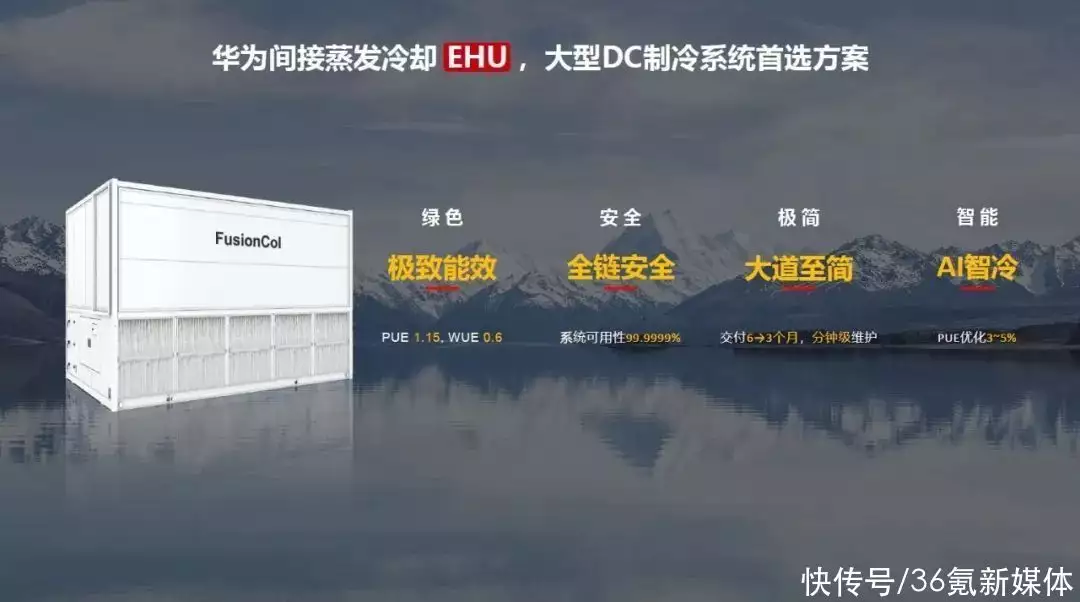

基于上述新挑战,华为新一代间接蒸发冷却解决方案EHU通过冷电融合技术,使得间接蒸发冷却设备在连续制冷、谐波处理等方面取得了全新突破。

在连续制冷方面,华为冷电融合架构允许机组备电直连,既能省去前端UPS,帮助客户节省配电间面积及CAPEX,且在双路切换压缩机0中断,机房温度0波动,实现真正的的0中断连续制冷!

在谐波治理方面,华为新一代间接蒸发冷却解决方案(EHU)集成PFC功能,有效将制冷设备满载运行谐波从30%以上降低到5%以下,直接从源头处解决谐波难题,保障供电链路安全可靠,同时将功率因素从原来的低于0.9的水平提升至大于0.99,能有效减少线缆选型以及断路器选型,进一步降低整体投资。

最后是基于AI的iCooling能效调优技术,AI服务器在交付前会预置初始训练模型,现场部署调测期间会5min/次对制冷系统进行点位数据采集(冷冻水系统:700+个点位;华为AHU/EHU:400+个点位),7天内建立本地AI训练模型。生成本地AI模型后,通过采集实时运行数据,10min内完成模型训练&推理,推理出最佳PUE调优策略,在1min内下将推理决策建议下发至制冷群控系统进行设备调控,冷冻水系统在2小时达到平衡,AHU/EHU在0.5小时达到平衡。当负载率或室外温差变化超过5%,华为iCooling会重新启动PUE寻优。

iCooling非常适合超大型/大型数据中心场景,比如IT实际负载≥5 MW以上的数据中心使用icooling基本可在2年内回收成本。华为iCooling已在运营商、金融、电力和人工智能行业客户数据中心广泛应用,比如河南联通中原基地、福建电信东南信息园、上交所金桥数据中心、三峡东岳庙数据中心、武汉人工智能计算中心。据华为iCooling应用案例统计,水冷冷冻水场景,运行PUE降低8%~15%;风冷冷冻水场景,运行PUE降低5%~10%;华为AHU/EHU场景,运行PUE降低3%~5%。

除上述之外,EHU在换热芯和风机等方面也进行了创新。例如换热芯方面,独有的Ice Cube高分子换热芯,采用翼型凸包设计,优化流动阻力,风阻降低13%;矩阵式波纹片,场协同原理,强化换热,换热效率提升5%。而在风机方面,自研的AeroTurbo风机,采用驱动分离式高效风机架构,实现了大风量(风量提升40%以上)、高效,风机效率提升4.5%,同时支持模块热插拔和极简维护(关键部件一分钟插拔维护)。

众所周知,数据中心建设快速增长是因为经济发展及市场应用的时代需求,而这种需求不只是体现在数据中心的建设数量,同时还有质量和效率。而在算力暴涨、能耗剧增、业务复杂多变的新形势下,传统数据中心建设模式面临的挑战正逐步显现,使其越来越不能满足市场应用的时代需求,并主要体现在建设周期长,无法满足业务快速上线需求;建设模式扩容难,难以实现按需扩容;建设模式设计PUE不可信,能耗居高不下;智能化程度待提高,运维难度大等四个方面。

基于此,站在整个数据中心发展的角度看未来,零碳DC、快速部署、架构极简、锂进铅退、全数字化、AI智能的结合及应用才是数据中心重构的发展方向,这体现着预制模块化数据中心的兴起。

以快速部署为例,互联网及云业务呈现短时间内快速爆发的特征,受疫情影响,业务侧数据和流量需求激增,快速部署成为刚需。此外,数据中心由支撑系统转为生产系统,需匹配云的应用需求,更快上线意味着更快收益,未来,数据中心TTM将从典型水平12-18 个月降低至6个月,甚至3个月。

又如架构极简,相对于传统数据中心建设缓慢和初期投资成本大的弊端,系统级和数据中心级架构极简将成为主流。数据中心供电/制冷架构将从传统架构向一体化链路级融合产品演进。在预制化、全模块化设计下,数据中心具备快速部署、弹性扩容、运维简单、高效节能等优势。

针对于此,华为发布了FusionDC 5.0生态解决方案,通过超融合极简架构+模块化+预制化理念,将融合创新发挥到极致,助力数据中心走向绿色化、智能化。其包括磐石结构2.0、高效制冷、高效供电和AI能效调优重新定义四大核心技术,实现从生产、建设、使用、回收全生命周期绿色低碳。

值得一提的是,在FusionDC 5.0生态解决方案中,华为采用1+4+N架构,聚焦包括生产制造、IHV和ISV、咨询设计、生态解决方案、集成交付、华为核心部件、物料供应等能力型伙伴,补齐产业拼图,构建端到端全场景的预制模块化生态解决方案,与伙伴一起推动模式升级。

以磐石结构2.0为例,其是华为与院士联合研发,它融合创新性支撑叠箱框架结构、仿榫卯构件连接、星阵式节点、组合式密肋蒙皮楼盖等多重先进技术和设计理念,凭借快、稳、准的优势和特性,得到建筑界的广泛认可,并荣获中国建筑学会科技进步奖。

需要说明的是,在新发布的FusionDC 5.0中,磐石结构2.0全面实现了小震不坏、中震可修、大震不倒、5层堆叠,8烈度抗震,12级抗风。

所谓实践出真知,华为上述的创新给客户带来了什么?在实践中表现如何自然是衡量其创新价值的硬指标。

以国内数据中心为例,华为云乌兰察布数据中心采用间接蒸发冷却方案和iCooling能效优化技术,实现了年均PUE低至1.15,和传统冷冻水方案相比,每年可节省耗电量超过3000万度,每年减少二氧化碳排放量约1.4万吨,真实践行了数据中心绿色节能和可持续发展。

又如华为廊坊云数据中心,基于AI(人工智能)的iCooling数据中心能效优化解决方案,可在给定的气候、业务等条件下,通过深度神经网络训练得出PUE预测模型,并下发执行及反馈效果,实现数据中心能效最优。以廊坊三期为例,在部署华为iCooling@AI能效优化解决方案后,年平均PUE从1.42降至1.25,年省电费约2000万元。

除了上述国内数据中心外,在国外数据中心也是如此。

例如欧洲爱尔兰某大型数据中心,由于采用华为间接蒸发冷却方案,实现全年自然冷却,PUE低至1.15,年省电超过1400万度,节省交付周期50%以上。

写在最后:可以看到,EHU和FusionDC 5.0的发布,是数据中心架构的创新和升级,将助力行业打造绿色、极简、智能、安全的面向未来的数据中心,让每一瓦特承载更多算力,更是牵引着行业加速迈向数字能源的新时代。

看未来,众木成林,众行致远。通过知识分享、行业使能、生态合作,打造创新合作开放平台、汇聚行业智慧、促进产业持续健康发展,是华为始终秉承的产业发展之道,由此业内对于其在预制模块化数据中心未来的表现自然更加期待。

相关标签: